本文4019字 阅读约需 11分钟

近日,OpenAI发表声明,向ChatGPT漏洞致部分用户信息泄露道歉。声明表示,早些时候,该公司将ChatGPT下线,原因是开源库中存在一个漏洞,致使一些用户可以看到另一用户的聊天记录标题。目前,该漏洞已被修复。

图源:社交平台截图

与所有具有创新功能的新技术一样,ChatGPT同样会带来数据安全与隐私风险。据数据安全公司Cyberhaven对其用户员工的分析,ChatGPT 的使用已经成为企业面临的严重问题,可能会导致敏感和机密数据的泄露。根据其调查,2.3% 的员工将公司机密数据粘贴到 ChatGPT 中,平均企业每周向 ChatGPT 泄露机密材料达数百次。

更严重的是,专家还警告说,企业安全软件无法监控员工的 ChatGPT 使用情况,也无法防止敏感/机密公司数据的泄露。

大量敏感信息面临泄露风险

数据安全公司Cyberhaven的研究人员分析了不同行业客户的160 万员工的ChatGPT 使用情况。其发布的报告称,自 ChatGPT 公开发布以来,5.6% 的知识工作者在工作中至少尝试使用过一次。,4.9% 的员工就向ChatGPT提供了企业数据,其中2.3% 的员工将公司机密数据贴入 ChatGPT。

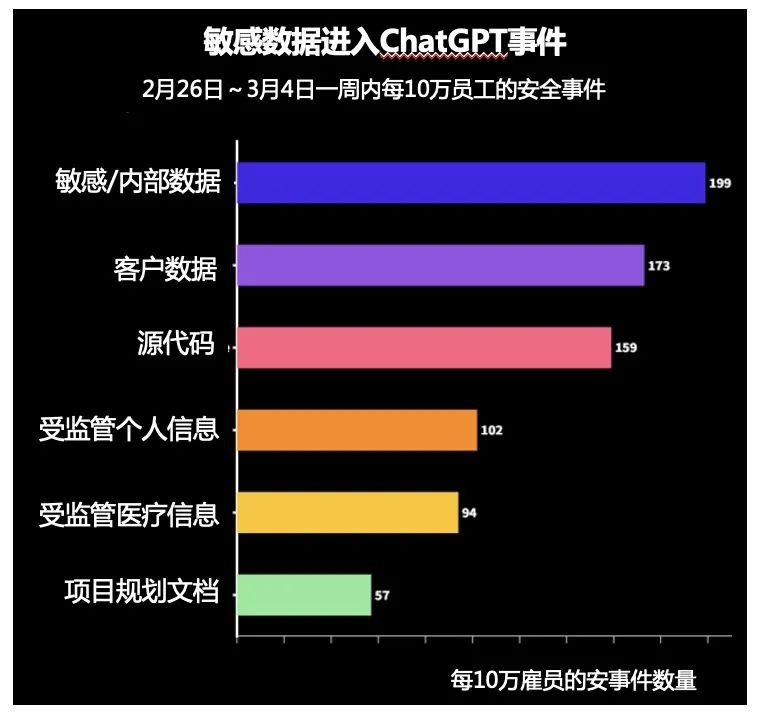

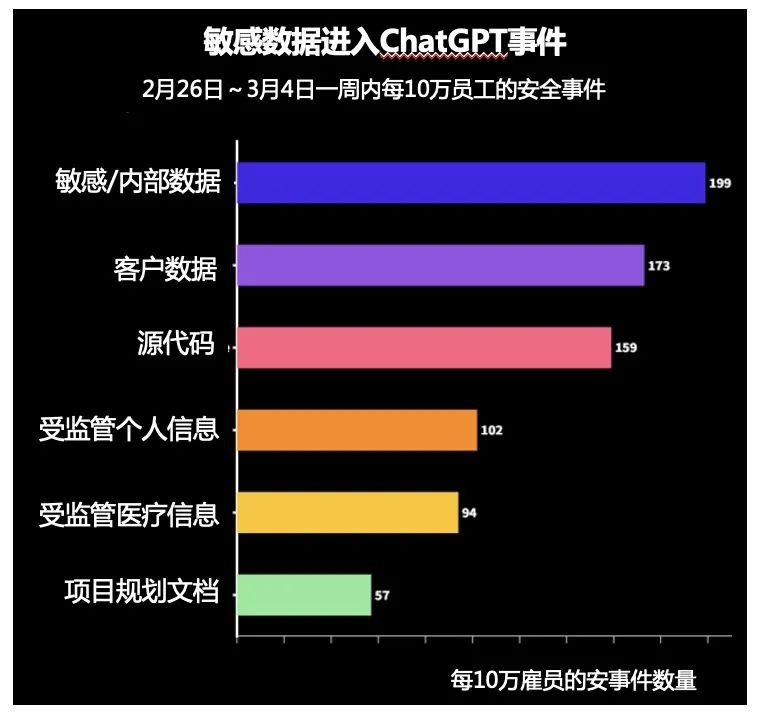

Cyberhaven研究人员指出,企业员工平均每周向 ChatGPT 泄露敏感数据达数百次,目前敏感数据占员工粘贴到 ChatGPT 的内容的 11%。例如,在 2 月 26 日至 3 月 4 日一周内,拥有 10万名员工的机构,向基于 AI 的聊天机器人提供机密文件199 次、客户数据173 次,以及源代码159 次。

出于对机密数据泄露的忧虑,美国银行、花旗集团、德意志银行、高盛集团、富国银行、摩根大通和 Verizon 等越来越多的机构禁止员工使用 ChatGPT 聊天机器人处理工作任务。 许多日本大公司也限制了ChatGPT 和类似聊天机器人的商业用途。该名单包括软银、富士通、瑞穗金融集团、三菱日联银行、三井住友银行等。

报告称,将公司数据粘贴到聊天机器人ChatGPT造成的泄漏,80%是由不到1% (0.9%) 的员工造成的。由于 ChatGPT 的使用率如此之高,且呈指数级增长,这意味着将会有大量敏感信息被粘贴到ChatGPT。随着更多服务通过API 集成ChatGPT技术,这一百分比在未来几个月内可能会迅速增加。

类ChatGPT给数据安全带来的三大隐患

截止目前,由ChatGPT直接产生的数据安全事件还不多,但由于其用户量激增,已经运行着海量数据,带来了数据安全风险隐患的担忧,比如在和AIGC对话时,是否带来个人隐私、敏感数据的泄露;AIGC在数据汇聚运算、数据输出使用时,安全如何保障,是否合规等。

具体来说,ChatGPT的数据安全风险体现在三个方面。

第一,敏感数据泄露的安全风险。

从数据安全与个人隐私的角度来看,ChatGPT 与各种用户进行交互,这就产生了敏感信息或个人信息可能在未经数据主体同意的情况下被共享的风险,还存在此类信息可能被用于进一步训练 ChatGPT 的风险。

年初以来,在发现ChatGPT生成的文本中有疑似商业机密的情况后,不少科技巨头开始提醒员工不要在使用ChatGPT时输入敏感信息数据。

据国外媒体报道,亚马逊的公司律师称,他们在ChatGPT生成的内容中发现了与公司机密“非常相似”的文本,怀疑可能是由于一些亚马逊员工在使用ChatGPT生成代码和文本时输入了公司内部数据信息,该律师担心输入的信息可能被用作ChatGPT迭代的训练数据。无独有偶,有微软员工曾在内部论坛上询问,能否在工作中使用ChatGPT工作时,微软首席技术官(CTO)办公室相关专家提醒不要将敏感数据发送给OpenAI终端,因为OpenAI可能会将其用于未来模型的训练。

国内法律专家认为,一旦与ChatGPT分享机密信息,这些输入的数据可能被用于未来模型的迭代训练,将会导致其所输出的内容可能包含用户提供的个人信息、机密数据或重要数据,造成敏感数据泄漏的风险。特别是对涉及国家核心数据、地方和行业重要数据,以及个人隐私数据的抓取、处理以及合成使用等过程中的安全保护与流动共享的平衡处置,这不仅涉及数据安全,还涉及国家安全、行业安全及个人安全等。

对ChatGPT的数据泄露风险,Verizon 首席信息安全官 Nasrin Rezai认为,使用 ChatGPT“会让我们面临失去对客户信息、源代码等控制的风险。”

第二,数据投毒带来安全隐患。

目前,国内类ChatGPT呈现出“大干快上”的局面,各科技巨头纷纷进场。从百度宣布推出的聊天机器人“文心一言”,复旦大学团队发布的国内首个类ChatGPT模型MOSS,京东的ChatJD,科大讯飞宣称将发布的AI学习机,以及阿里研发的内测类ChatGPT机器人等等,国内一场由ChatGPT引发的人工智能新浪潮已经袭来。

然而,国内的类ChatGPT架构远未到成熟阶段,不可避免的存在AI漏洞,容易被攻击者利用,对数据进行污染,加入了伪装数据或者恶意样本,即所谓的“数据投毒”, 造成算法模型结果的错误,进而导致巨大的数据安全隐患。

有研究表明,当攻击者通过将恶意数据如伪装数据、恶意样本等,注入到用于类ChatGPT模型的训练集中,会让模型产生不正确或误导性的结果。这种看似正确、实则“一本正经的胡说八道”的回复,在商业化中会造成严重后果,甚至有法律风险。

此类例子也屡见不鲜。例如微软过去的一个聊天机器人Tay因发布歧视性和攻击性言论而被关闭,主要原因就是在对话数据集里面被恶意增加了不当的数据。一旦类ChatGPT被恶意利用,通过诱导性数据进行模型训练,可能生成虚假信息、诱骗信息等不良信息,破坏网络舆论生态。恶意使用者还能够生成大量用户名和密码的组合,用于对在线账户的撞库攻击,导致更大的安全问题。

第三,数据跨境流通带来的合规风险。

根据ChatGPT原理,用户在输入端口提出问题后,该问题会传输到位于美国的OpenAI公司,随后ChatGPT给出相应回答,该回答便会输入到用户端口以实现对问题的反馈。在这个过程中,数据的出境与入境作为服务的开端和结尾,都存在着一定的法律风险。尤其是在数据出境这一方面,网民所提出的问题中极有可能涉及到个人信息、敏感信息甚至有关国家安全、经济运行、社会稳定、公共健康和安全的重要数据,一旦触及合规红线,相关企业和个人就可能面临巨额处罚。

《数据安全法》第三十一条规定指出:向境外提供重要数据的,由有关主管部门责令改正,给予警告,可以并处十万元以上一百万元以下罚款,对直接负责的主管人员和其他直接责任人员可以处一万元以上十万元以下罚款;情节严重的,处一百万元以上一千万元以下罚款,并可以责令暂停相关业务、停业整顿、吊销相关业务许可证或者吊销营业执照,对直接负责的主管人员和其他直接责任人员处十万元以上一百万元以下罚款。

AIGC时代,数据安全该做哪些功课?

数据安全的重要性已经不言而喻。在以ChatGPT为代表的AIGC浪潮之下,对于企业而言,该如何应对来自数据安全的挑战呢?

针对企业使用ChatGPT面临的信任、风险和安全问题,Gartner建议实施AI安全政策,禁止员工向ChatGPT 询问可能泄露机密企业数据的问题;此外,对于ChatGPT 服务,还需要用人工审核输出结果,以发现不正确、误导或有偏见的信息。

奇安信数据安全专家给出了以下建议:

首先,要识别敏感信息,做好重要数据分级分类,避免数据和隐私泄露。

在使用ChatGPT等AIGC工具之前,企业应该识别被视为敏感、重要的信息类型,例如财务数据、经营战略、商业机密、个人敏感信息等,并对重要、敏感数据进行分级分类,根据属性来定义每种类型数据所需的保护级别。

与此同时,要限制对敏感信息的访问,对敏感信息的访问应该是仅限于有业务需求并接受过数据安全培训的人员。同时,企业需要使用加密和访问控制等措施,并定期监控和审计员工的 AIGC使用情况。

对于任何数字化过程中的企业而言,最紧迫的工作是盘清资产:包括系统梳理在线的敏感数据数据库、以及特权账号等数据资产,并形成数据资产梳理报告。进而做好精准保护,包括做好特权账号管理,做到能审查、能告警、能拦截,并能快速响应处置等等,避免AIGC成为新的数据风险敞口。

其次,通过数据验证、数据清洗等技术预防对抗样本和数据投毒。

安全专家预测,国家背景的黑客将率先在网络攻击中利用ChatGPT,而该技术最终会在更多的攻击组织得到大规模的使用。安全专家需要用好人工智能这一工具,以AI对抗AI,帮助安全人员提高效率,提高恶意软件识别、抵御网络攻击的能力。

人工智能毕竟是机器,很难像人类一样鉴别善与恶。帮助防止数据投毒的一种方法是,开发AI模型的科学家定期检查其训练数据中的所有标签是否准确。OpenAI公司提出的解决方案是,当其研究人员策划他们的数据集时,他们会定期通过特殊的过滤器传递数据,以确保每个标签的准确性。

举个例子,由于AI接受了从互联网上抓取的数千亿个单词的训练,而庞大的训练数据集包含有害言论,会被人工智能学习。为了建立安全系统以控制这种危害,OpenAI借鉴了Facebook等社交媒体的做法:即给人工智能提供有关暴力、仇恨言论和虐待的例子,检测器就可以学会检测言论危害。将检测器内置到ChatGPT中,就可以在仇恨言论到达用户之前将其过滤掉,还可以帮助从人工智能的训练数据集中清除有害文本,来保障数据尽可能是干净的。

当然,这是一场猫和老鼠的游戏,从数据源头来保证不被污染,进而提升数据收集、运算、输出、使用等全链条的安全性,是人工智能必须破解的课题。

最后,企业守好合规底线,尤其是解决好数据跨境合规问题。

“合规不踩线”是企业经营的重要基石,使用境外的类ChatGPT产品,做好数据跨境的合规审计是企业的必修课。其中包括建立数据出境风险自评估、进行数据出境安全评估申报、构建数据出入境安全事件应急处置机制等。

奇安信推出的数据跨境卫士,正是数据安全建设中重要的一环,不仅能解决企业跨境传输的数据能满足《数据安全法》、《个人信息保护法》、数据跨境监管等合规要求,还能对敏感数据的跨境流动情况,进行全局、清晰和直观的掌控。

目前,奇安信数据跨境卫士具有四方面功能,首先是保障合规,即帮助企业满足《数据安全法》、《个人信息保护法》、数据跨境监管相关条例等合规要求;其次是可查可检,满足企业正常业务开展的同时,清晰掌握业务数据、重要数据、个人信息等敏感数据跨境流动详情;第三是及时止损,可以帮助企业避免名誉受损、经济受损,同时避免被通报处罚;最后是看清流向,可以全面了解WHO(什么人)、WHEN(什么时间)、WHERE(什么地点)、HOW(什么方式)、WHAT(什么数据)等整个数据跨境流转的整个过程,实现全局掌控。

以ChatGPT为代表的AIGC,正在掀起以人工智能为代表的第四次工业革命浪潮。然而,该技术带来的数据安全隐患,包括数据获取、隐私泄露、恶意滥用、跨境合规等等,亟待引起业内的重视,方能让AIGC更好的服务人类,成为安全高效、不可或缺的工具、。

关于作者

张少波 虎符智库研究员

本文来自《网安26号院》2023年3月刊ChatGPT专题

立即拨打

立即拨打

京公网安备11000002002064号

京公网安备11000002002064号